【协和医学杂志】自动化文献筛选工具在系统评价中的应用

时间:2024-09-14 06:01:47 热度:37.1℃ 作者:网络

近几十年来,科技的高速发展促生了新的医学思想,医学模式从传统的经验医学逐渐向循证医学(EBM)转变。区别于传统医学,EBM更强调医疗决策应建立在科学研究的基础之上,获取高质量的研究证据用于临床决策支持对EBM研究至关重要[1]。

EBM的主要证据载体为系统评价,即针对某一特定临床问题,系统、全面收集国内外所有发表或未正式发表的研究成果,严格采用文献评价原则和方法,筛选出符合纳入标准的研究文献,并对其进行定性或定量分析,得出综合可靠的结论。

评价者在进行系统评价时,为尽可能降低偏倚带来的影响,需首先对特定的临床研究文献进行检索,如随机对照试验(RCT)等。为保证检索的系统性,评价者最常采用的策略是查全率极高(即灵敏度98%以上)、查准率较低(即特异度75%以下)的检索策略[2],结果往往得到远超于实际需求量的文献题录。

在接下来的文献筛选阶段,评价者按照文献纳入和排除标准(研究对象、干预及对照措施、结局指标、研究设计和方法学质量)进行手动纳入或排除时,任务则十分繁重。调查研究表明,发表1篇系统评价在文献阅读和筛选阶段需临床研究者投入大量精力,平均每篇系统评价完成发表需要67.3周[3]。随着发表文献数量的不断增加,若仍采用传统方法,则无法对当前的证据进行迅速、有效整合,往往导致系统评价因发表滞后而时效性变差。

随着人工智能技术的发展,越来越多的研究人员开始关注如何以自动化的方式完成医学领域文献的识别、筛选等工作[1],一批自动化文献筛选工具应运而生。这些工具应用机器学习(ML)、文本分类等技术,可实现文献的自动分类标注,包括检索特定研究类型文献以及对文题和摘要等进行自动筛选,排除不相关文献,最终采纳符合要求的文献[4],对提高系统评价撰写效率具有重要意义。本文旨在对现有用于系统评价文献筛选的自动化工具进行整理汇总,以期为系统评价研究人员应用相关工具提供参考。

1 RCT检索筛选工具

RCT被认为是疗效评估的金标准,而系统评价是针对特定临床问题的所有RCT的严格综合,因此被认为是最可靠的证据形式。研究者经常手动筛选数千条不相关的记录,以期找到一部分相关的RCT[5]。虽然数据库自带的索引可完成筛选任务,但却无法兼顾查全率与查准率。

以PubMed数据库为例,对某单一术语进行检索,在该数据库发表类型(PT)一栏索引的“randomized controlled trial”中,仅包含了93.7%的RCT,仍有6.3%的RCT未检出,特异度为97.6%,非RCT文献占2.4%,可见仅依靠数据库自带的索引,无法满足系统性检索高查全率的要求。若通过增设多条检索式扩大检索范围,针对RCT的检索灵敏度虽可达99.5%,但其特异度又降至45.5%[2]。近年来,基于深度学习的自然语言处理技术取得了一定进展,并开始应用于医学领域尤其是文献处理,也促进了RCT检索筛选工具的发展。

1.1 Cochrane Crowd

2016年5月,Cochrane协作网推出了一个研究者社区平台Cochrane Crowd(https://crowd.cochrane.org/),以实现对RCT的筛选。该平台使用众包和ML混合筛选的方法,先基于支持向量机(SVM)模型训练一个RCT分类器,然后使用此RCT分类器根据文献标题和摘要将所有文献先筛选一遍,如果模型以足够高的置信度(概率≤0.1)预测该文献不是RCT,则无需人工审查而直接排除,其余文献(概率>0.1)再由人工根据全文进行筛选。最终评估结果显示,被模型排除的17 495条非RCT中仅有32条为RCT(假阴性),使用Cochrane Crowd筛选RCT能保持98%的灵敏度,同时保持99.8%的特异度,与仅依靠手动筛选相比,可节省60%~80%的工作时间[6]。

1.2 RobotSearch

Marshall等[7]于2016年应用ML算法开发并评估了一种RCT过滤器RobotSearch,比广泛使用的传统数据库过滤器能够更好地区分RCT。该程序的基础是SVM模型和卷积神经网络(CNN)模型,另外可以选择性结合PT标签。

用户在使用前需根据训练集训练得到稳定模型,将模型参数载入RobotSearch,然后在数据库进行搜索时先不选择数据库自带的传统过滤器,将搜索结果题录以RIS格式输入RobotSearch,生成1个仅包含RCT文章的过滤列表。

开发者以不同阈值点的灵敏度和特异度为轴绘制受试者操作特征(ROC)曲线,而ROC曲线下面积是一种常用的评估分类模型性能的指标,分别绘制使用SVM、CNN、SVM+CNN、SVM+PT、CNN+PT和SVM+CNN+PT模型分类时的曲线图,结果表明集成SVM+CNN+PT的模型在区分RCT时效果最佳,曲线下面积达0.987(95% CI:0.984~0.989)[7]。

另外,开发者比较了RobotSearch与Cochrane高灵敏度RCT过滤器(Cochrane HSSS,灵敏度为98.5%,特异度为76.9%)的性能,RobotSearch设置灵敏度为98.5%时,其特异度高达87.6%,显著高于Cochrane HSSS。

RobotSearch相较于传统数据库过滤器的一个关键优势是可根据需求从ROC曲线中选择任意截点,例如,如果研究人员需要比Cochrane HSSS更高的灵敏度,根据开发人员提供的ML算法以不同截点的灵敏度和特异度电子表格作为参考,可获得99.1%的灵敏度和77.2%的特异度截点。

值得注意的是,目前PT标签由PubMed团队人工标注,从文章发布到标注通常有250 d的滞后时间,依赖此标签的传统过滤器和ML方法将缺失最近的研究数据,一定程度上会影响结果的准确性。

2 文献纳排筛选工具

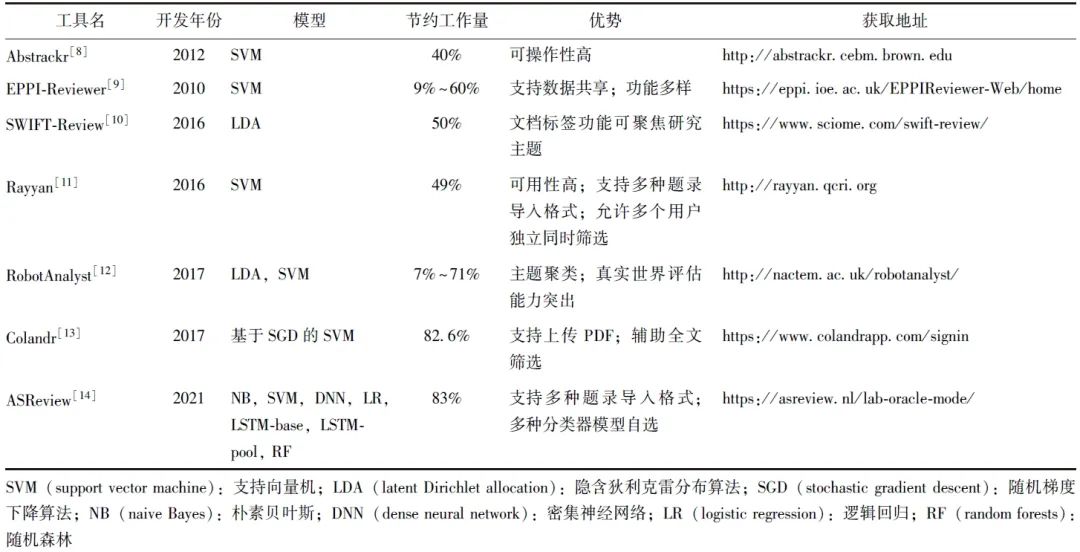

对于检出的大量文献,研究者会基于制定的纳排标准,根据文献的题目和摘要进行初步筛选,目前初筛领域的自动化筛选工具研究已初见成效。这些工具(表1)经过人工训练出模型后,会自动识别文题和摘要中描述PICOS(Population,Intervention,Comparison,Outcome and Study design)原则的句子以决定文献是否被纳入。

表1 初筛领域的自动化筛选工具

经过初筛后,再基于全文内容排除不符合纳入标准的文献,即文献复筛。由于文献复筛所需的全文内容主要是以PDF的文件格式存储,计算机无法直接读取,需先将PDF转化为xml、txt等可读取的文本形式。受文字排版影响,转化过程中很容易发生语句混乱等错误,目前尚缺乏成熟的转化手段,亦无具有代表性的可直接用于自动化全文筛选的工具。

2.1 Abstrackr

Abstrackr(http://abstrackr.cebm.brown.edu)是一个用于初筛领域的免费半自动化ML工具。Abstrackr的底层结合了主动学习的SVM模型,可通过研究者的筛选决策不断学习[8]。

使用Abstrackr筛选时,需先将检索到的所有文章题录导出上传至软件中,然后根据系统提示选择审阅设置,包括研究人员数量(1人或2人)、查看题录的顺序(随机或按相关性)等,每个用户界面上将依次呈现标题、作者、摘要和关键字等,系统会提示研究者将每个题录标记为相关、不相关或不确定,逐条筛选。在研究者人工判断一定数量(500条/10 000条)的文献后,工具会采用内置模型预测文本的相关性,并对余下未筛选的文本进行相关性排序。另外,研究者可标记表示相关或不相关的术语。例如,在纳入初级研究时,“系统性综述”或“综述”可被标记为无关,模型会利用相关性术语进行筛选。

为降低高质量证据的检索遗漏率,Cohen等[15]假设系统需要95%或更高的召回率,并创建了新的评价标准WSS@95以评估不同分类模型的性能。WSS(work saved over sampling)表示在一定召回水平下所节省的工作量,WSS@95即召回率为95%时,文献按相关性排序相较于简单随机排序可以减少的文献筛选工作量。理论上WSS越接近于1,表明减少的文献筛选工作量越接近100%。WSS为0或负值则表明,该分类模型未减轻使用者的工作负担。经WSS@95评估,Abstrackr模型减少了研究者约40%的工作量。

在用户评测环节,参与者一致认为Abstrackr是最容易操作的工具之一。其缺点是功能单一,有时会卡顿或者崩溃,缺少文件导出功能,部分参与者表示其使用指南并不能起到很好的指导作用[16]。

2.2 EPPI-Reviewer

EPPI-Reviewer[9](https://eppi.ioe.ac.uk/EPPIR eviewer-Web/home)是伦敦大学学院开发的用于系统评价的云平台,已被用于数千篇系统评价,涉及健康、社会护理、教育等众多主题。该软件用户界面清晰,能够跨机构进行协作。最新的版本支持数据共享,可有效减少全球系统评价人员的大量重复工作。与Abstrackr原理相似,同为基于SVM模型的半自动化监督学习工具,软件在对检出文献文题和摘要筛选时,需先“学习”用户的纳入或排除标准,建立数据训练模型,再使用模型对剩余的文献进行优先级排序以完成筛选。

Tsou 等[17]最早评估了Abstrackr和EPPI-Reviewer的性能,对于多份大型报告,筛选负担的潜在减少分别为4%~49%(Abstrackr)和9%~60%(EPPIReviewer),仅从数据来看,EPPI-Reviewer效率更高,但二者差距无统计学意义。

另外,EPPI-Reviewer还具有用于识别RCT、系统评价等的ML分类器,但尚未见相关研究测评文献发表。

2.3 SWIFT-Review

SWIFT-Review(https://www.sciome.com/swift-review/)是一个基于隐含狄利克雷分布算法(LDA)的免费半自动化监督学习工具,对于文题和摘要的文献筛选,特别是对于具有大量文献基础的主题更有优势[10]。SWIFT-Review允许用户以包含PubMed ID(PMID)列表的文件或PubMed搜索结果的XML形式上传题录,然后训练模型,完成余下筛选。Howard等[18]比较了SWIFT-Review与其他筛选工具(Cohen 2006、Matwin、Cohen 2008)的性能,对于相同的15个公共数据集,SWIFT-Review在其中11个中表现优异。

此外,SWIFT-Review的文档标签功能在聚焦研究主题时非常有用。当题录导入到SWIFT-Review中时,每条题录都会自动与各种“标签”相关联,这些“标签”将题录分为不同类别。用户可使用SWIFT-Review的“标签浏览器”,根据这些标签交互过滤导入的题录。SWIFT-Review标签包括各种导入的元数据,如MeSH词、MeSH补充概念词和从文档中自动提取的各种主题,以及用户手动添加的任何其他标签。SWIFT-Review的缺陷是其公开版本目前仅适用于PubMed数据库。

2.4 Rayyan

Rayyan(http://rayyan.qcri.org)是由Ouzzani等为加快文题和摘要筛选开发的免费程序[11],相较于同类型其他工具,Rayyan在使用过程中反应更灵敏、表达更直观,对新客户更友好,可用性很高,在减轻研究者文献筛选负担方面具有巨大潜力。Rayyan本身用开源框架RubyonRails编写并在基于亚马逊Web服务的云平台Heroku上运行,高峰时段可随用户数量的增长相应扩展,满足存储需求的同时避免使用卡顿。

Rayyan支持多种标准格式导入题录,例如RefMan RIS和EndNote等,当用户手动将部分导入文献标记为排除或纳入时,Rayyan即调用SVM分类器学习这些排除和纳入文献的特征,并相应构建分类器模型筛选剩余的文献,比较独特的功能是,Rayyan允许2个或更多用户同时、独立筛选参考文献并在最后比较结果。

2.5 RobotAnalyst

RobotAnalyst(http://nactem.ac.uk/robotanalyst/)是由公益组织国家文本挖掘中心(NaCTeM)开发的基于LDA和SVM模型相结合的文献筛选系统,主要应用于文献初筛[12]。系统首先会对主题相近的文献进行聚类,然后根据用户反馈的信息对文献进行优先级排序。其提供的主题建模和聚类分析探索参考文献集合功能,可将无共同关键词但具有相同主题的参考文献放在一起,对于制定涉及多个复杂问题的公共卫生指南极为有益。

虽然许多软件利用主动学习优先级排序来辅助系统评价筛选,但已发表的研究主要限于对先前完成的系统评价进行交叉验证。Przybyła等[12]对RobotAnalyst、EPPI-reviewer、Abstrackr、SWIFT-Review、Rayyan、Colandr等筛选工具进行了真实世界评估,结果表明RobotAnalyst在对相关文献进行优先级排序时能力更加突出,对于各种特定的数据训练模型,可节省7%~71%的工作量。

另外,RobotAnalyst页面布局设计良好,导出文件功能便捷,缺点是其后台服务器经常卡顿,使得用户体验感较差,在筛选文献的过程中往往因系统问题导致工作效率低下,且其筛选流程复杂,对从未接触过类似工具的新手来说不够友好[12]。

2.6 Colandr

Colandr(https://www.colandrapp.com/signin)是Samantha团队与数据科学非营利组织DataKind合作创建的免费开放访问平台[13],该平台使用基于随机梯度下降算法(SGD)的SVM分类器进行自动化文献筛选和数据提取。初筛操作步骤与其他工具相似,仅支持RIS格式文件导入。不同的是,Colandr支持上传全文PDF,拥有识别PDF文件中描述PICOS原则的句子,可帮助研究人员加快全文筛选速度,缺点是无PDF批量上传选项,每次只能手动上传1篇文章。该团队评估了Colandr实际减少的工作量,约为82.6%。

2.7 ASReview

ASReview(https://asreview.nl/lab-oracle-mode/)是由荷兰乌得勒支大学开发的免费开源机器学习工具,该软件与多个引文管理器(Zotero、EndNote、Mendeley和Refworks)连接,方便在完成筛选后自主选择引文管理器导入文档继续工作[14]。在使用过程中,ASReview支持扩展名为.csv、.tab、.tsv或.xlsx等多种格式的数据集导入,默认的分类器模型为朴素贝叶斯(NB),但同时可选择SVM、密集神经网络(DNN)、逻辑回归(LR)、长短期记忆人工神经网络(LSTM)、随机森林(RF)等多种模型,另外在筛选时如不小心错误分类,ASReview可在“历史记录”页面更改决策。经评估,ASReview召回率为95%时,平均节省的工作量为83%,在目前所有自动化筛选工具中最高[19]。

3 问题与对策

自动化文献筛选工具在系统评价领域具有广阔的应用空间,但目前仍存在如下问题亟待解决。

自动化文献筛选工具的更新发展以深度学习算法为基础,需要同时具备丰富临床知识和语言学知识的专家来制定算法规则,而目前大多数研究者不熟悉机器学习的算法模型,未来需加快复合型人才的培养,以满足自动化文献筛选工具亟需不断更新完善的需求。

目前大多数自动化文献筛选工具基于监督学习进行文本分类和数据筛选,不同项目需依赖使用者的人工分类结果进行深度学习从而获得不同的训练数据,筛选结果易受主观因素影响。例如,若上传的人工分类数据量较小,可能导致筛选模型过度拟合;若上传的人工分类结果质量较低,模型识别筛选的能力也会下降[20]。未来若在文献收录之时就将研究设计类型、患者、疾病、干预、暴露因素、结局指标等进行恰当标注,将大大减少人工分类结果的影响,提高自动化文献筛选工具的效率。

自动化工具的使用现状并不乐观。Altena等[21]对来自22个国家的100名参与者进行了调研,仅32%的参与者在工作中使用了自动化工具,自动化工具的使用和推广还存在诸多障碍,包括成本高、程序复杂、用户界面不友好等多个问题。未来应做好这些工具的用户测试和反馈意见收集工作,从而不断改进和完善。

现有的自动化工具主要针对英文医学文献,人工智能应用于中文医学文献的筛选尚处于空白状态。英文文本的处理相对简单,因为单词之间有空格或标点符号隔开,如不考虑短语,一般只需要分割单词,去除标点符号、空格即可。相对于英文来说,中文的文本预处理则更为复杂,在处理中文文本时,需利用分词算法进行分词处理,并去掉停用词,这些复杂的步骤增加了中文文本分类的难度,也导致针对英文的算法并不能直接套用于中文[2]。未来应加强基于机器学习的自然语言算法在系统评价领域的成果转化[22],以利于更加快捷且功能多样的文献筛选工具出现,并早日填补中文医学文献自动化筛选工具的空白。

4 小结与展望

近年来,自动化文献筛选工具取得了飞速发展,但目前其在系统评价领域的应用仍较少。ChatGPT等里程碑式人工智能技术的出现,或可对系统评价过程,包括文献筛选和信息提取的自动化产生深刻影响,推动文献筛选工具的更新及其在系统评价领域中的推广应用,从而加快循证证据合成,为临床实践指南的撰写和更新提供高质量信息,促进临床医疗决策更加科学化。

参考文献

[1]杨丰春, 徐晓巍, 李姣. 循证医学研究中的证据自动更新方法研究[J]. 中国数字医学, 2022, 17(1): 44-49.

[2]毛渤淳, 陈圣恺, 谢雨, 等. 经典深度学习算法对中文随机对照试验智能判别应用[J]. 中国循证医学杂志, 2019, 19(11): 1262-1267.

[3]Borah R, Brown A W, Capers P L, et al. Analysis of the time and workers needed to conduct systematic reviews of medical interventions using data from the PROSPERO registry[J]. BMJ Open, 2017, 7(2): e012545.

[4]张雪芹, 张薇, 郑培永, 等. 计算机辅助系统评价方法学研究和应用[J]. 中国循证医学杂志, 2021, 21(1): 111-116.

[5]McKibbon K A, Wilczynski N L, Haynes R B, et al. Retrieving randomized controlled trials from medline: a comparison of 38 published search filters[J]. Health Info Libr J, 2009, 26(3): 187-202.

[6]Wallace B C, Noel-Storr A, Marshall I J, et al. Identifying reports of randomized controlled trials(RCTs) via a hybrid machine learning and crowdsourcing approach[J]. J Am Med Inform Assoc, 2017, 24(6): 1165-1168.

[7]Marshall I J, Noel-Storr A, Kuiper J, et al. Machine learning for identifying randomized controlled trials: an evaluation and practitioner's guide[J]. Res Synth Methods, 2018, 9(4): 602-614.

[8]Wallace B C, Small K, Brodley C E, et al. Deploying an interactive machine learning system in an evidence-based practice center: Abstrackr[C]//Proceedings of the 2nd ACM SIGHIT International Health Informatics Symposium. New York, NY: Association for Computing Machinery, 2012: 819-824.

[9]Park S E, Thomas J. Evidence synthesis software[J]. BMJ Evid Based Med, 2018, 23(4): 140-141.

[10]Gates A, Gates M, Sebastianski M, et al. The semi-automation of title and abstract screening: a retrospective exploration of ways to leverage Abstrackr's relevance predictions in systematic and rapid reviews[J]. BMC Med Res Methodol, 2020, 20(1): 139.

[11]Ouzzani M, Hammady H, Fedorowicz Z, et al. Rayyan-a web and mobile app for systematic reviews[J]. Syst Rev, 2016, 5(1): 210.

[12]Przybyła P, Brockmeier A J, Kontonatsios G, et al. Prioritising references for systematic reviews with RobotAnalyst: a user study[J]. Res Synth Methods, 2018, 9(3): 470-488.

[13]Cheng S H, Augustin C, Bethel A, et al. Using machine learning to advance synthesis and use of conservation and environmental evidence[J]. Conserv Biol, 2018, 32(4): 762-764.

[14]Van De Schoot R, de Bruin J, Schram R, et al. An open source machine learning framework for efficient and transparent systematic reviews[J]. Nat Mach Intell, 2021, 3(2): 125-133.

[15]Cohen A M, Hersh W R, Peterson K, et al. Reducing workload in systematic review preparation using automated citation classification[J]. J Am Med Inform Assoc, 2006, 13(2): 206-219.

[16]Gates A, Johnson C, Hartling L. Technology-assisted title and abstract screening for systematic reviews: a retrospective evaluation of the Abstrackr machine learning tool[J]. Syst Rev, 2018, 7(1): 45.

[17]Tsou A Y, Treadwell J R, Erinoff E, et al. Machine learning for screening prioritization in systematic reviews: comparative performance of Abstrackr and EPPI-reviewer[J]. Syst Rev, 2020, 9(1): 73.

[18]Howard B E, Phillips J, Miller K, et al. SWIFT-Review: a text-mining workbench for systematic review[J]. Syst Rev, 2016, 5: 87.

[19]李世磊. 基于文献相似度的系统评价引文筛选系统的设计与实现[D]. 成都: 电子科技大学, 2020.

[20]Marshall I J, Wallace B C. Toward systematic review automation: a practical guide to using machine learning tools in research synthesis[J]. Syst Rev, 2019, 8(1): 163.

[21]Van Altena A J, Spijker R, Olabarriaga S D. Usage of automation tools in systematic reviews[J]. Res Synth Methods, 2019, 10(1): 72-82.

[22]陈耀龙, 罗旭飞, 史乾灵, 等. 人工智能如何改变指南的未来[J]. 协和医学杂志, 2021, 12(1): 114-121.